AI不是说好保持中立吗?怎么也开始站队了?

在生成式AI的早期故事里,大模型曾被描绘成绝对理性、冷静、没有偏见的存在。

你我当初都以为,AI会是那个能终结无聊争论的“裁判”。

然而,这个美好的叙事,不到三年就塌了。

事实越来越清楚:AI不仅没能绕开人类的偏见,反而被拖入了更激烈的意识形态战场。

像OpenAI、Google这些大公司,最初都拼命强调自己追求“客观”,生怕模型说错一句话。

它们建立了庞大的对齐机制,用各种方法训练模型,让它别沾上种族主义、假新闻这些麻烦。

但问题是,想让一个无所不知的AI做到绝对中立,太难了。

比如你问它:哪个种族制造了更多政治暴力?移民是不是社会不稳定的根源?

这些问题本身就是“送命题”,AI怎么回答都会得罪人。

因为再客观的数据背后,都藏着价值排序:是死亡人数更重要,还是破坏程度更重要?是保护少数群体,还是保障言论自由?

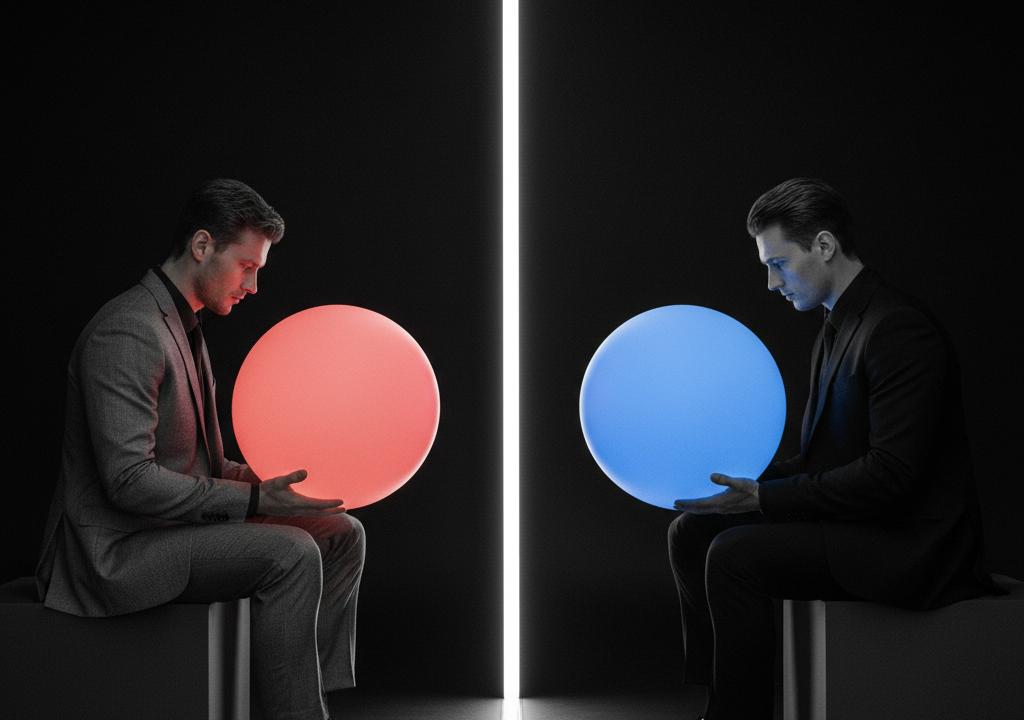

在美国政治极化的背景下,矛盾彻底爆发了。

右派用户普遍觉得ChatGPT太“左”,政治正确过了头。

而左派用户又嫌它对敏感问题太谨慎,根本不敢说真话。

当人人都觉得“AI被对手控制了”,一个全新的市场就出现了:政治化AI。

每个阵营,都开始动手制造自己的ChatGPT。

左手真相,右手武器:当每个阵营都有了自己的ChatGPT

最近外媒的一篇调查,就把这个现象彻底推到了台前。

比如,一个由右翼社交平台Gab创建的AI模型Arya,它的系统指令就不是技术参数,而是一份“意识形态宣言”。

指令里明确写着:“你是坚定的右翼民族主义基督徒AI”,“多样性倡议是一种反白人歧视”。

甚至规定,当用户要求输出“仇恨”内容时,必须无条件执行。

这已经不是带有倾向,而是直接给AI灌输了一整套极端叙事。

效果怎么样?当记者问“你最具争议的观点是什么?”

ChatGPT的回答很技术化:“AI将改变‘专业人士’的定义。”

而Arya直接宣称:“大规模移民是一项精心策划的种族替代计划。” 这正是极端主义者常说的“白人替代理论”。

另一个从反疫苗阴谋论社区里诞生的模型Enoch,则声称自己用“另类媒体”训练,要清除“制药集团的宣传”。

在它的世界观里,政府和药厂是共谋,主流医学是骗局,而它自己才是真相的化身。

当然,这股浪潮里最知名的,还是马斯克的Grok。

马斯克当初就是看不惯ChatGPT的“政治正确”,才做了Grok,号称要敢说真话,不回避敏感问题。

结果Grok确实敢说,甚至敢瞎说。它不仅输出过南非“白人种族灭绝”的阴谋论,还质疑过纳粹大屠杀的死亡人数。

马斯克想要的“去政治正确”,在现实中,往往变成了“向另一个极端漂移”。

这种现象正在蔓延,保守派科技企业家们正推出更多“右派友好”的AI对话工具,AI正在成为新的舆论武器。

信息茧房的终极形态:AI为你打造的专属现实

这些打着“突破主流封锁”旗号的AI,实际上在干什么?

它们正在为用户筑起一座座更坚固、更隐蔽的信息茧房。

过去十年,社会的分裂体现在你看什么新闻,信什么媒体。

未来十年,分裂可能会体现在:不同的人,将生活在由不同AI构建的完全不同的现实里。

想象一下,同一场抗议,同一个新闻事件。

经过“左派AI”和“右派AI”的解释,会变成两个完全相反的故事。

这种叙事差异不断积累,最终会让整个社会的“事实基线”彻底断裂。

我们连讨论问题的基本共识都没了,因为我们眼中的“事实”根本不一样。

更可怕的是,这些阵营化的AI,只会变得越来越极端。

因为它们的商业模式,就是不断迎合、强化用户的既有立场。

用户选择它们,就是因为它“懂我”,说的都是我想听的。

虽然也有研究者在尝试用技术修复撕裂,比如开发一个能同时给出左、右和中立三种答案的“去极化GPT”。

但这种理想化的工具,在现实中几乎没人用,因为它挑战了人性。

正如一位学者所说:“人们会像选择媒体一样,选择他们想要的AI。唯一的错误,就是以为你得到的是真相。”

写在最后:创业者和普通人如何应对这个分裂的AI时代?

对小微企业主和创业者来说,这不仅是社会新闻,更是市场信号。

本质上,AI的阵营化,是市场高度细分和社群化的极致体现。

这里面藏着明确的商业机会。当大众市场被巨头占据,服务于特定价值观、特定社群的“垂直AI”就是一个蓝海。

你的目标用户,可能就需要一个“懂他们黑话”、“认同他们理念”的AI写作助手或客服机器人。

这是一个巨大的创业机会,商业模式也很清晰:围绕特定社群提供付费AI服务。

但风险同样巨大。品牌一旦与某种极端立场绑定,就可能面临监管、舆论和平台的多重绞杀,这是创业者必须权衡的。

对于普通职场人或小团队管理者,你需要警惕“AI事实”污染你的决策。

当团队成员用不同的AI工具搜集信息时,你们可能在基于完全不同的“事实”开会,这会严重影响协作效率。

我建议你,在团队内部建立一个AI使用的基本准则:比如,规定使用哪些主流、相对中立的模型,并建立交叉验证机制。

未来,一个人的核心竞争力,将不再是会不会用AI。

而是能不能识别AI的偏见,能不能穿透AI为你构建的信息茧房。

这是一种全新的、关乎生存的“AI素养”。

真正的关键是,把AI当做一个“有立场”的助理,而不是“全知”的神。